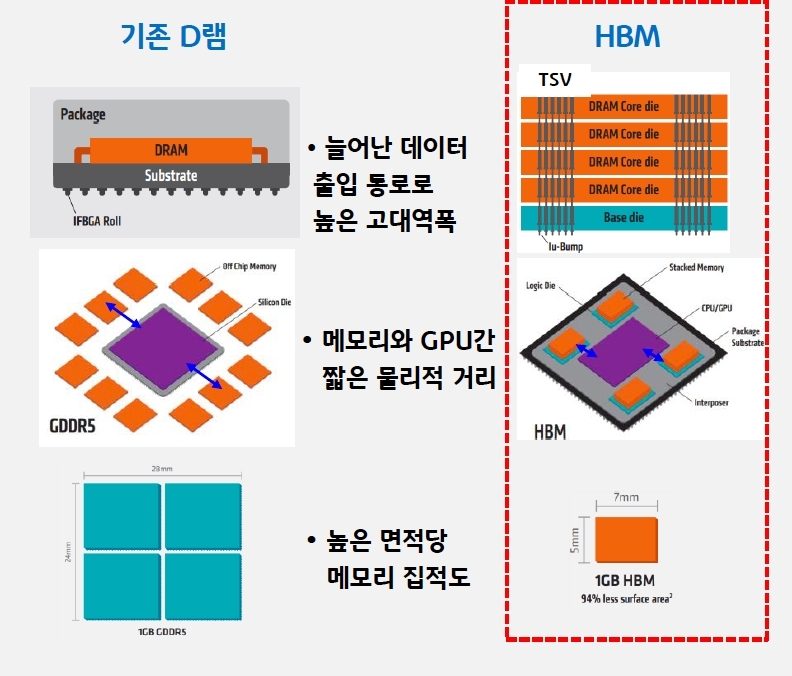

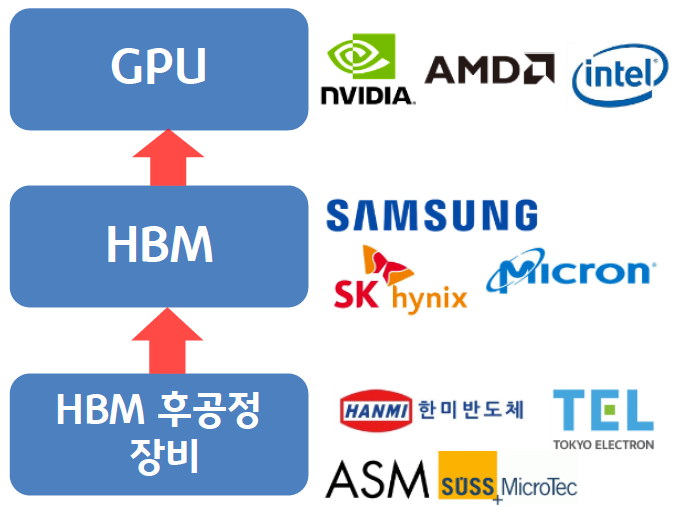

일반적 기능의 기존 메모리로는 고성능과 고효율을 필요로 하는 인공지능 시스템 등을 구축하는 데 한계가 있음

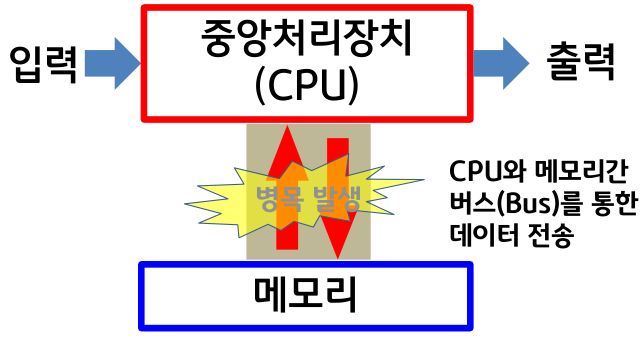

- 전통적인 컴퓨터 설계 기법인 폰 노이만 구조⁴에서는 CPU와 메모리(D램)를 연결하는 통로(Bus)를 통해 데이터가 이동하며 연산을 수행

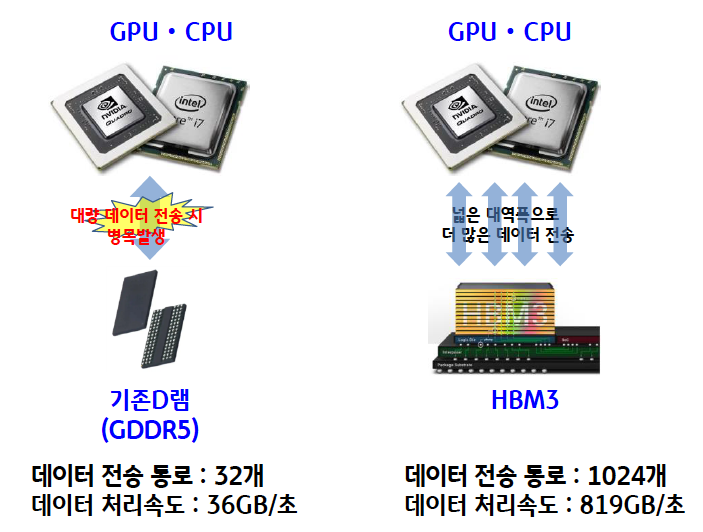

- CPU가 아무리 빨라도 인공지능과 같이 처리해야 할 데이터량이 증가하면 데이터 이동이 지연되면서 시스템 전체의 성능이 저하하는 병목 현상이 발생

- 이런 문제점은 현대 컴퓨터 구조가 바뀌지 않는 이상 오늘날 글로벌 반도체 기업들이 해결해야 할 과제