○ 오픈AI사가 공개한 chatGPT는 인간과 자연스러운 대화가 가능하다는 점에서 큰 주목을 받으며 사용자 확산

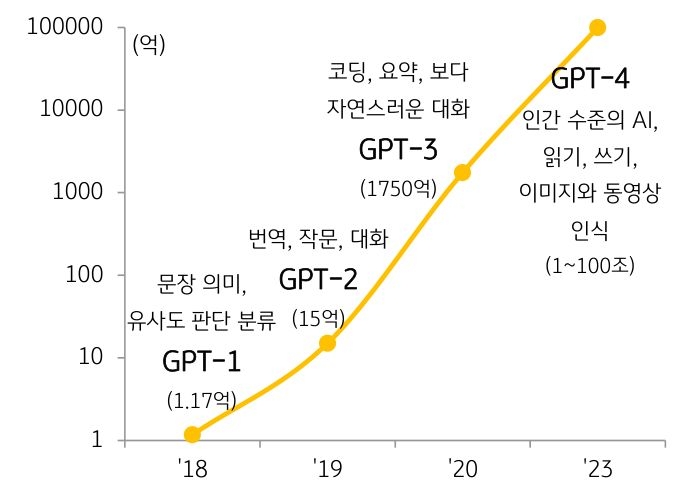

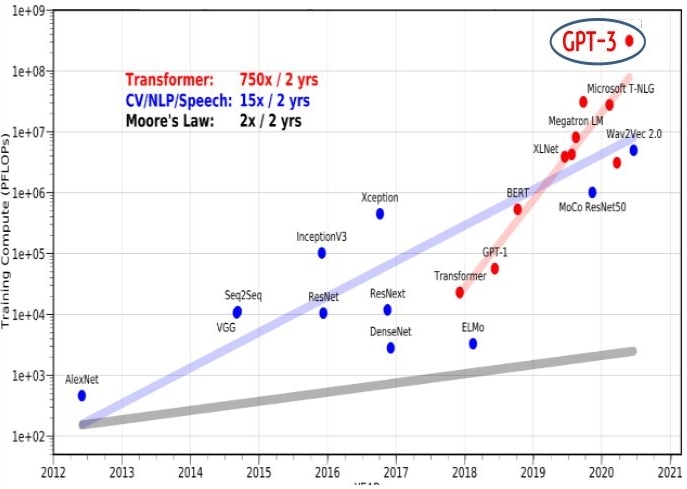

- 미국 인공지능 기업 오픈AI는 초거대 AI(Super-Giant AI)¹인 GPT-3 출시에 이어 GPT-3.5 버전인 ‘chatGPT’를 2022년 11월에 공개²

– 인간의 언어를 이해하며 자체적으로 판단하고 행동하는 수준으로 발전 중인 초거대 AI는 대화 및 코딩, 정보전달, 문서 작성 까지 가능한 chatGPT로 진화

- chatGPT는 기술 완성도가 아직 미흡하다는 의견도 있으나, 자연스러운 대화를 통한 활용 확대로 창작, 코딩, 번역, 검색, 텍스트 요약 등 광범위한 영역에서 파급효과가 클 것으로 기대

– 공개 5일만에 사용자 수가 100만명을 넘어섰고 2개월 만에 월간 이용자수 1억명을 돌파하는 기록을 세움