○ 챗GPT의 뛰어난 성능은 생성형 AI¹, 특히 거대언어모델에 대한 관심과 호기심을 촉발

- AI 언어모델의 기본 구조는 단어 사이 연관성을 파악하여 언어의 맥락을 유추하는 것

- 예를 들면 “맛있는”이라는 단어 뒤에는 “사과”, “바나나” 등의 단어가 올 확률이 상대적으로 높기 때문에 이러한 단어 사이에 높은 연관성이 부여

- 문장은 단어와 다른 단어를 어떤 순서로 나열했는가에 따라 의미가 달라지는데, 기존 언어모델은 문장을 한 단어씩 순서대로 읽기 때문에 긴 문장을 처리하는 데 속도가 매우 느렸고, 단어 사이 관계를 기억하는 데 한계가 존재

- 정체기에 접어들었던 언어모델 분야는 2017년 구글이 ‘트랜스포머(Transformer)’라는 딥러닝 모델을 오픈소스로 공개하면서 또 한 번의 기술적 진보를 이룸²

- 트랜스포머 모델은 입력된 문장 내 단어의 순서를 코드화하고, 각 단어를 중요도에 따라 가중치를 부여하는 방식으로 기존 알고리즘(순환신경망(RNN)이나 콘볼루션신경망(CNN))³ 보다 정확도를 획기적으로 향상시킨 것

- 아울러 모델의 학습 시간을 단축시킬 수 있는 병렬 처리가 가능해지면서 자연어 처리 뿐만 아니라 이미지 인식 및 분류, 번역 등에 보다 널리 활용되기 시작

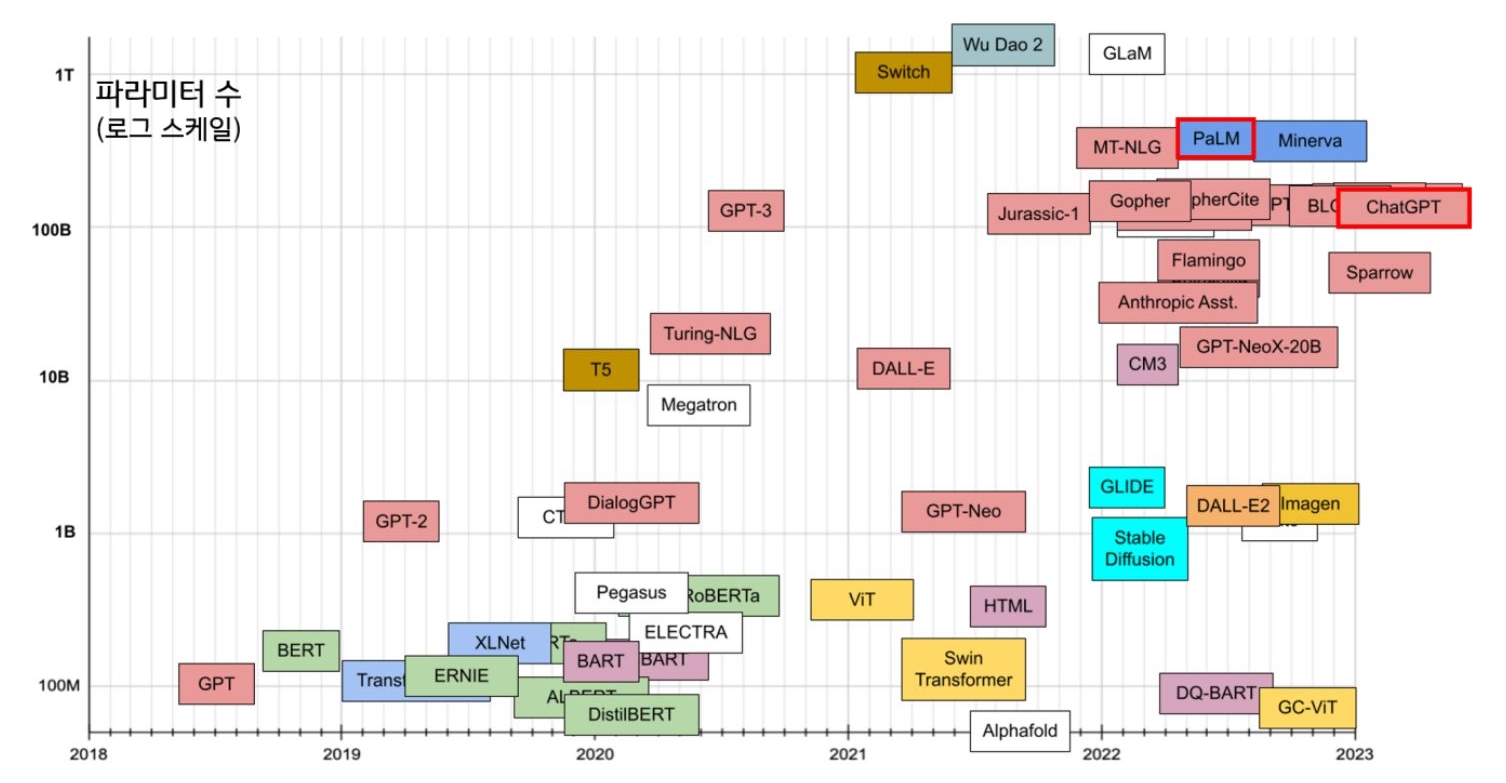

- 최근 화제가 된 오픈AI(Open AI)의 GPT(Generative Pre-trained Transformer), 구글의 PaLM(Pathways Language Model, 팜)도 트랜스포머 모델에 기반한 거대언어모델(LLM, Large Language Model)

- 거대언어모델은 매개변수(파라미터) 개수가 성능에 큰 영향을 미치는 것으로 알려지면서, 2021년을 기점으로 수천억 개의 매개변수가 사용된 모델들이 줄지어 등장

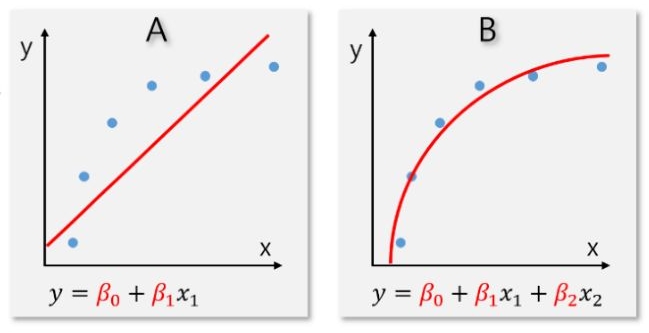

- 신경망 언어모델의 확장에 관한 연구⁴에 따르면 매개변수 개수, 데이터셋의 크기, 학습에 필요한 연산량이 클수록 성능이 뛰어남

- 오픈AI의 GPT-3.5는 1,750억 개⁵ , 구글의 PaLM은 5,400억 개의 매개변수가 사용되었으며⁶, 최근에는 1조 개가 넘어가는 초거대언어모델도 등장. 다만 매개변수 개수가 증가할수록 투입되어야 하는 자원과 비용도 천문학적으로 늘어난다는 점에서 ‘모델의 크기가 크다고 더 좋은 것만은 아니다’는 의견도 존재⁷