■ AI 오케스트레이션에서 ‘모델 콘텍스트 프로토콜(Model Context Protocol, MCP)’은 AI 모델과 데이터 소스 및 도구 간의 상호작용을 표준화하여 조직 내 AI 접근성과 활용성을 크게 향상시키는 핵심 요소로 부상

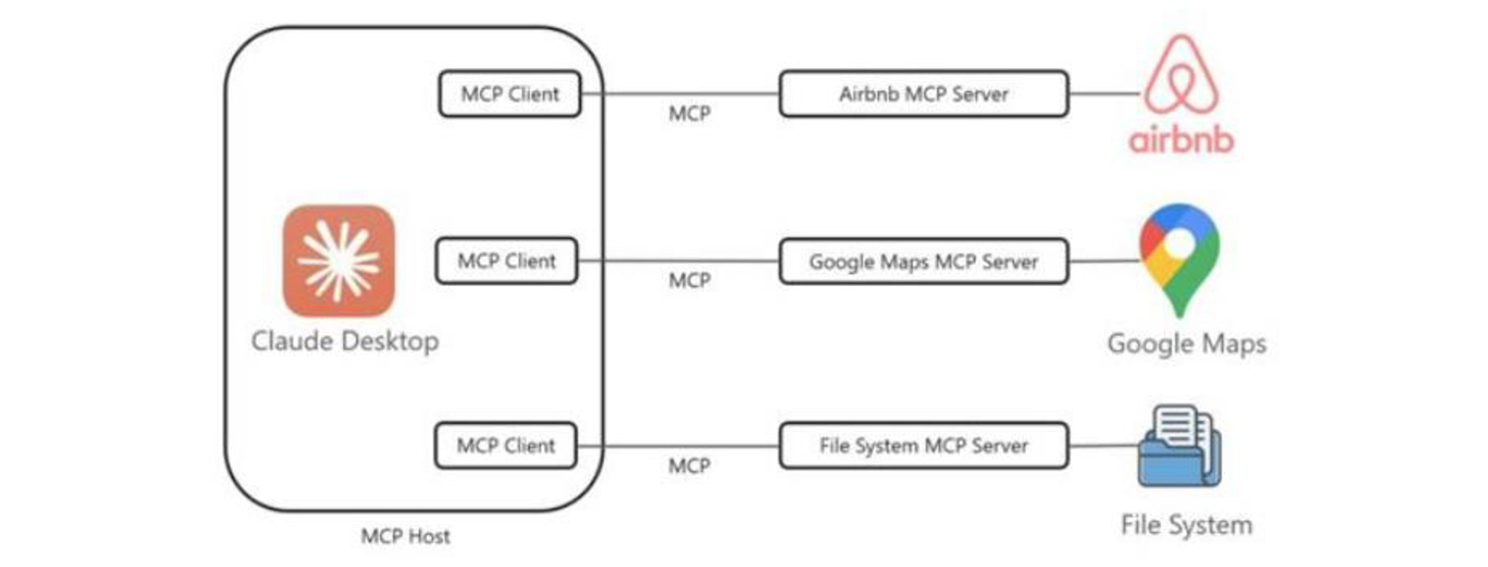

○ MCP는 LLM이 검색·데이터베이스·연산 등 외부 도구를 상황에 맞게 선택적으로 호출하고 연동할 수 있도록 도와주는 에이전트 인터페이스 프로토콜로, 앤트로픽이 2024년 11월 오픈소스로 공개

- USB-C 포트가 다양한 기기를 하나의 표준 단자로 연결하듯이 LLM과 콘텐츠 저장소, 비즈니스 애플리케이션, 개발 도구 등 여러 시스템을 단일한 방식으로 연결

- 이처럼 기존의 각기 다른 API 및 플러그인 방식을 통합해 AI 시스템이 필요한 콘텍스트와 데이터를 원활히 얻을 수 있게 함으로써 LLM이 ‘지능형 오케스트레이터’로서 기능할 수 있게 해줌

- 특히 금융, 법률, 컨설팅과 같이 연속적 해석과 판단이 중요한 도메인¹³에서는 MCP가 없으면 실질적인 자동화가 어려움

- 복잡한 업무 요청도 AI가 자체적으로 판단하여 최적의 도구를 적절히 조합

- 기존 LLM API는 단순한 질의응답 구조이기 때문에 콘텍스트 유지가 어렵고 업무 연속성이 낮다는 문제점을 안고 있는데, MCP를 적용하면 마치 업무 도우미처럼 AI가 일관된 콘텍스트로 업무 수행을 보조

- MCP 개발 전에는 추가 도구를 활용해 콘텍스트 관리를 일부 지원했으나 개발과 유지보수가 어렵다는 단점이 존재